Recueil de questions posées à :

L’oral de l’examen de vérification d’aptitudes aux fonctions de programmeur de système d’exploitation (MAJ selon Programme de l’épreuve oral - arrêté du 11 décembre 2006)

L’épreuve commune de l’écrit de l’examen de vérification d’aptitudes aux fonctions de programmeur de système d’exploitation

l’épreuve de spécialité du concours IEF Informatique

SOMMAIRE

la représentation de l’information

1 Les fonctions arithmétiques ?

2 Qu’est-ce que Big Indian et Little Endian ?

3 Comment se présente un nombre en virgule flottante et en virgule fixe?

4 Qu’est-ce qu’une instruction ?

5 Qu’est qu’un code détecteur d’erreur, un code correcteur d’erreur ?

6 Qu’est qu’un contrôle de parité, de double parité ?

7 Qu’est ce qu’un code de Hamming ?

9 Composants d'une carte mère et leurs fonctions ?

10 Archi RISC par rapport à CISC ?

11 Quels sont les différents modes d’adressage de la mémoire pour un processeur ?

12 Les types de mémoires (temps d'accès, capacité, coût) ?

13 Qu'est-ce qu'une mémoire associative ? Avantages ?

14 Avantages, inconvénients de la technologie RAID ?

15 Différence entre RAID 0 et Raid 1 ? Description du Raid 5 ?

16 Comment se caractérise la transmission de l’information ?

17 Qu’est-ce que la « gigue » ? Quelles sont les solutions pour palier à la gigue ?

19 Différences entre Half et Full duplex ?

20 Différences entre interruption, exception et déroutement ?

21 Qu’est-ce que la multiprogrammation ?

22 Qu’exprime le taux de multiprogrammation ?

23 Comment est segmentée la mémoire centrale d’un ordinateur ?

24 Qu’est ce que la mémoire virtuelle ?

26 Quelles sont les différentes stratégies d’allocation de la mémoire ?

27 Qu’est-ce qu’un progiciel ?

28 Définition d'un processus ? Etat, Ordonnancement ?

29 Définition d’un processus UNIX ?

31 Qu’est–ce qu’une exécution en mode noyau ou utilisateur ?

32 Qu’est-ce que la commutation de contexte ?

33 Comment se décompose la segmentation de la mémoire pour un processus ?

Communication inter ou intra processus

35 Quels sont les différents moyens de communication inter processus ?

36 Quels sont les différents moyens de synchronisation entre les processus ?

38 Qu’est-ce qu’un interblocage ?

39 Quelles sont les solutions pour éviter les interblocages ?

40 Qu’est-ce qu’un sémaphore ?

41 Citer des problèmes récurrents auxquelles répond l’utilisation des sémaphores ?

42 Qu’est-ce qu’un Mutex (exclusion mutuelle) ?

43 Qu’est-ce que l’inversion de priorité ?

44 Qu’est-ce qu’un signal (UNIX)?

45 Qu’est qu’un système d’exploitation ?

46 Qu’elles sont les fonctions d’un système d’exploitation ?

47 Citez des exemples de système d’exploitation ?

48 Les systèmes d'exploitation réseau ?

Architectures de systèmes ou de processus

49 Quels sont les avantages et les inconvénients d’un système centralisé ?

50 Quels sont les avantages et les inconvénients d’un système distribué ?

51 Qu’est qu’une architecture Client/Serveur?

52 Architectures 3 tiers ? N tiers ?

53 Qu’est-ce qu’un machine virtuelle ? Différence avec runtime ?

54 Garbage collector ? Les algorithmes ?

55 A quoi sert un masque de réseau ?

56 Qu’est-ce qui différencie une adresse de classe A, B et C ?

57 Qu’est-ce qu’une adresse Ethernet ?

58 Qu’est-ce qu’un adresse de diffusion ?

59 Différentes topologies réseaux logiques ?

61 Quelles sont les différences entre IPV4 et IPV6 ?

63 Les types de réseau en ordre croissant ?

64 Définition Internet, Intranet, Extranet ?

67 A quoi sert la qualité de service sur un réseau IP ?

68 Quels sont les critères de la qualité de service ?

69 Qu’est-ce que le routage ? Citez et expliquez les différents algorithmes existants ?

71 Quels sont les risques en sécurité pour un réseau WIFI ?

72 Quelles sont les techniques pour sécuriser les réseaux sans fils WIFI ?

74 Quelles sont les différentes architectures du WPA ?

77 Qu'est-ce q'un VLAN ? Quels sont ses avantages ?

79 Quelles sont les normes qui définissent les VLAN ?

80 Quels sont les types d’équipement qui gère les VLAN ?

81 Qu'est-ce que RPV ? Correspondance de ses protocoles selon le modèle OSI ?

84 Qu’est-ce que l’UDP ? Qu’est-ce qui le caractérise ?

85 Qu’est-ce que le Diffserve ?

86 Qu’est-ce que le Intserve ?

87 Qu’est-ce qu’un web service ?

88 Qu'est-ce qu'un méta annuaire ?

90 Quelles sont les fonctions du protocole LDAP ? Que permet-il ?

91 Quelles sont les différences entre un annuaire et une base de donnée ?

92 Serveur de temps ? Architecture pour en gérer plusieurs ?

93 Mécanisme de SSO (Single Sign On)? Architectures ?

95 Qu’est-ce que la MIB ? Usage et rôle ?

96 Quelles sont les contraintes du temps réel sur IP ?

97 La téléphonie sur Internet ?

98 Qu’est-ce que le protocole SIP ?

99 Quelles sont les contraintes spécifiques à la vidéo conférence sur IP ?

100 Différences entre un Switch et un Hub. Que permet de plus le Switch ?

101 Qu’est ce qu’un Répéteur ?

105 Qu’est-ce qu’un passerelle ?

106 Les différentes normes de câblages Ethernet ? Débits et portées ?

107 Qu’est-ce que Manchester Bi-Phasé ?

108 Les différents types d’attaques par réseau?

110 Quel résultat du scan de la pile TCP/IP d'un serveur ?

111 Comment protéger un serveur des tentatives de scan de la pile TCP/IP ?

112 Objectifs d'un scan ? Comment masquer une intrusion sur un serveur ?

114 Qu’est-ce qu’un IDS (détecteur d'intrusion) ?

115 Quelles sont les différentes techniques de détections d’un IDS ?

116 Quelles sont les différentes actions d’un IDS ?

119 Entrepôt de données (data warehouse) ?

120 Quelles sont les différences entre un entrepôt de données et une base de données ?

121 Qu’est-ce qu’un Datamart ?

123 DAS, NAS et SAN ? Mode d'accès aux données ?

124 Qu'est-ce que la virtualisation du stockage de donnée ?

126 Quels sont les objectifs (les 4 principes) de la sécurité informatique ?

127 Quelles sont les moyens mis en ouvre pour s’assurer de la sécurité d’un système informatique ?

128 Décrivez de manière détaillée la sécurité d’un centre informatique ?

130 Quelles sont les différentes techniques de recherche de virus par un antivirus?

131 Qu’est-ce que le Buffer Overflow?

132 Quels sont les objectifs de la cryptographie ?

133 Quelles sont les différences entre un chiffrement asymétrique et un chiffrement symétrique ?

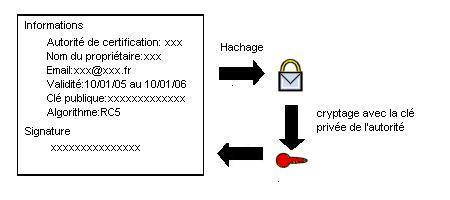

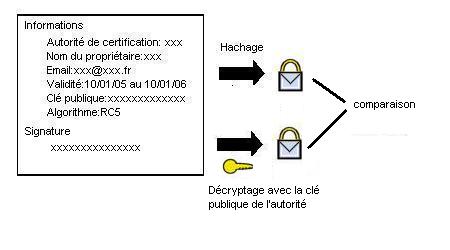

134 A quoi sert un certificat ?

136 Les familles d'algorithme de chiffrement (nom, mode de fonctionnement, exemple) ?

137 A quoi sert une fonction de hachage ?

138 Citez des exemples d’algorithme de chiffrement symétrique et expliquez leur fonctionnement ?

139 Citez des exemples d’algorithme de chiffrement asymétrique et expliquez leur fonctionnement ?

140 Citez des exemples de fonctions de hachage et expliquez leur fonctionnement ?

141 Les fonctions d'un CTI ? Citez différentes architectures ?

143 Qu’est-ce que du pseudo-code (ou langage intermédiaire) ?

144 Qu’est-ce qu’un langage impératif ?

145 Qu’est-ce qu’un langage procédurale (ou fonctionnel) ?

146 Les différences entre langage procédurale (ou navigationnel) et assertionnel ?

147 Les différences entre un compilateur et un interpréteur ?

148 Programmation événementielle ?

149 Les catégories de langages ?

150 Qu’est-ce qu’un Framework ?

152 Quelles différences entre exécutable compilé en statique et en dynamique ?

153 Quelles sont les informations rajoutées à un programme compilé en mode « Debug » ?

154 Avec quoi peut travailler une équipe de programmeur ?

155 Qu’est-ce qu’un sous-programme réentrant ?

159 La surcharge de classe, de fonction ?

160 Différence entre héritage statique et dynamique ?

161 Qu’est-ce qu’un algorithme ? Caractéristiques ?

162 Récursivité ? Structures adaptées pour ça ?

163 Quelles sont les différentes techniques de parcours d’arbres ?

165 Les algorithmes de tri ? Ordre de rapidité ?

166 Cycle de vie du logiciel ?

168 Citez et expliquez des méthodes d’analyse ?

169 Qu’est-ce qu’un Design Pattern ?

172 Quels sont les différents modèles logiques d’une BD ?

174 Différences entre un SGBD et la gestion de fichiers ?

175 Citez des SGBD OpenSources ?

176 Qu’est-ce qu’un jointure ?

177 Quelles sont les 4 propriétés essentielles d'un sous système de traitement de transactions ?

181 Quels sont les objectifs de la licence GNU GPL ?

184 Single Unix Specification ?

185 CNIL ? Rôle, quand rentrer en contact avec elle ?

186 Définition de la qualité au sens ISO ? Qualité interne et externe ?

190 Qu'est-ce qu'XML (parser + DTD) et ces fonctionnalités. différence par rapport à SGML ?

191 Quel est le rôle d’une DTD ? Qu’est-ce qu’un document bien formé ou valide ?

193 Qu’est-ce qu’un Workflow ?

194 Quelles sont les différentes typologies de workflow ?

195 Qu’est-ce qu’un moteur de workflow ?

196 EAI (Enterprise Application Integration) ?

197 Qu’est ce que l’informatique décisionnelle ?

201 Qu’est-ce qu’un service dans une architecture SOA ?

202 Qu’est-ce que l’urbanisation?

Ce sont des principes d’organisation des octets en mémoire. Ils définissent la position des octets d’un entier.

Soit A un entier codés sur 64 bits, Ax avec l’octet d’indice x de A

Little Indian : famille de processeur x86, Vax

Adresse 0 :

|

A3 |

A2 |

A1 |

A0 |

Adresse 4 :

|

A7 |

A6 |

A5 |

A4 |

Big Endian : famille de processeur IBM 360/367, 68x00 Motorolla, PowerPC

Adresse 0 :

|

A0 |

A1 |

A2 |

A3 |

Adresse 4 :

|

A4 |

B5 |

B6 |

A7 |

Virgule fixe :

|

K partie entière |

K décimale |

K nombre de bit

Le K de gauche représente la partie entière du nombre

Le K de droite la partie décimale

Virgule flottante :

N = M x BE N : Nombre M : Mantisse E : Exposant B : Base

La mantise donne une précision finie. Si la taille de la mantise augmente alors la précision augmente aussi.

Stockage en mémoire IEEE 754 (32 bits et 64 bits) :

|

SM Signe de la Mantise 1 bit 1 bit |

E Exposant 8 bits 11 bits |

M Mantise 23 bits 52 bits |

Une instruction est une opération exécutable par un processeur sur des données. Elle se compose d’un code opératoire et d’opérandes

Code détecteur d’erreur :

C’est une information (1 ou plusieurs bits) rajouter à un groupe de bit permettant de vérifier si une erreur existe.

Exemples : contrôle de parité ; contrôle de double parité

Code correcteur d’erreur :

C’est une information (1 ou plusieurs bits) rajouter à un groupe de bit permettant de reconstituée l’information initialise si une erreur s’est introduite.

Exemple : code de Hamming, CRC.

Contrôle de parité :

Le control de parité est une méthode pour détecter des erreurs dans des données (ensemble de bits). Le principe consiste à rajouter 1 bit qui indique sur un nombre de bits surveillés, si le nombre de bit à 1 est pair ou impair.

Contrôle de double parité :

C’est un contrôle de parité en ligne et en colonne sur un groupe de bits rangés en tableau à 2 dimensions.

C’est un code correcteur de d’erreur.

M + k = n bits avec K bits de parité

Cyclic Redondant Coding est un code correcteur d’erreur.

Ses bits de contrôle sont générés à partir d’un polynôme appliqué sur les données à surveiller.

RISC : Reduced Intruction Set Computer

CISC : Complex Instrucion Set Computer

|

Registre |

Add R4, R3 |

R4 <= R4 + R3 |

La valeur est dans un registre |

|

Immédiat ou littéral

|

Add R4, #3 |

R4 <= R4 + 3 |

Pour les constantes |

|

Déplacement ou basé |

Add R4, 100(R1) |

R4 <= R4 + M [100 + R1 |

Accès aux variables locales |

|

Indirect par registre |

Add R4, (R1) |

R4 <= R4 + M [R1] |

Accès en utilisant un pointeur ou une adresse calculée |

|

Direct ou absolue |

Add R4, (1001) |

R4 <= R4 + M [1001] |

Accès aux variables statiques |

|

Indirect par mémoire |

Add R4, @(R1) |

R4 <= R4 + M [M [R1] ] |

Si R1 est l’adresse d’un pointeur p alors ce mode donne *p |

|

Indexé étendu |

Add R4, 100(R1)[R3] |

R4 <= R4 + M [ 100 + R1 + R3*d ] |

|

|

Auto incrément |

Add R1, (R2) + |

R4 <= R4 + R3 |

|

|

Auto décrément |

Add R4, - (R2) |

R4 <= R4 + R3 |

|

Dans l’ordre croissant du temps d’accès et des capacités :

registre du CPU,

mémoire cache,

mémoire centrale ou mémoire vive (RAM),

mémoire d’appuis (Swap),

mémoire de masse.

Caractéristiques techniques :

La capacité, représentant le volume global d'informations (en bits) que la mémoire peut stocker ;

Le temps d'accès, correspondant à l'intervalle de temps entre la demande de lecture/écriture et la disponibilité de la donnée ;

Le temps de cycle, représentant l'intervalle de temps minimum entre deux accès successifs ;

Le débit, définissant le volume d'information échangé par unité de temps, exprimé en bits par seconde ;

La non volatilité caractérisant l'aptitude d'une mémoire à conserver les données lorsqu'elle n'est plus alimentée électriquement.

Ainsi, la mémoire idéale possède une grande capacité avec des temps d'accès et temps de cycle très restreints, un débit élevé et est non volatile.

Néanmoins les mémoires rapides sont également les plus onéreuses. C'est la raison pour laquelle des mémoires utilisant différentes technologiques sont utilisées dans un ordinateur, interfacées les unes avec les autres et organisées de façon hiérarchique.

Figure 22 : Hiérarchie mémoire en fonctions du temps d'accès et de la capacité

Mémoire cache : centaines de Ko à 4 Mo, mémoire très rapide ; entre CPU et la RAM ; stocke instruction et données ; mémoire associative

Mémoire associative : adressable par le contenu (1 clé <=> 1 contenu); recherche de la présence de l’information dans la mémoire en 1 seul cycle ;

Avantages : Rapidité (Exemple : mémoire cache du processeur)

RAID : Redundant Array of Inexpensive / Independent Disk

Le RAID peut être géré de deux façons :

Par voie

logicielle, la partition système ne peut bénéficier

du mode RAID puisque c'est elle qui le gère (à

l'exception du mode Mirroir "RAID1").

Avantages : peu

cher, souple, compatible.

Inconvénients :

consommateur de CPU ; pas en partition système.

Par voie

matérielle, le système est plus rapide et devient

transparent pour le système d'exploitation dont la partition

peut ainsi être intégré dans le

RAID.

Avantages : détection des défauts,

le remplacement à chaud des unités défectueuses

et offrent la possibilité de reconstruire de manière

transparente les disques défaillants ; peu consommateur

de CPU.

Inconvénients : compatibilité ;

souplesse d’administration et d’évolution.

Les techniques :

La concaténation : nombre quelconque de volume bout à bout pour présenter 1 seul volume logique (peu fiable : 1 panne tout en panne)

Agrégation par bandes (stripping) : concaténation mais en découpant préalablement en bandes de taille fixe un nombre quelconque de volume de données de taille identique. On alterne alors une bande de chaque volume pour créer le "volume agrégé par bandes".

Le miroitage (mirroring) : plusieurs unités de stockage de données pour stocker des données identiques sur chacune (cher ; fiable ; pas d’augmentation des performances)

Redondance par calcul de parité : consiste à déterminer si sur n bits de données considérés, le nombre de bits à l'état 1 est pair ou impair (RAID 5)

Avantages :

Augmenter la capacité, grâce aux agrégats de partitions qui permettent de créer des partitions s'étendant sur plusieurs disques.

Améliorer les performances, grâce au « striping » qui permet de lire et d'écrire sur plusieurs disques simultanément pour en augmenter le débit. (voir RAID 0).

Apporter la tolérance de panne, on se prémunit ainsi contre les défaillances disque.

Raid 0 :

Figure 22 : Raid 0

Appelé aussi Striping, les données sont réparties sur au moins deux disques sous la forme d'agrégats par bandes.

Cette méthode de

gestion des disques améliore uniquement la vitesse en

lecture et en écriture. Le débit de la grappe de

disque en RAID 0 est égal au débit d'un disque

multiplié par le nombre de disque. Elle n'apporte aucune

sécurité des données, la perte d'un disque

entraîne la perte des données de tous les disques de la

grappe.

Ce mode est recommandé pour la production d'image, de vidéo.

Raid 1 :

Figure 22 : Raid 1

Appelé aussi

"Mirroring ou Duplexing". Le Mirroring utilise un

seul contrôleur pour tous les disques, alors que le duplexing

utilise un contrôleur par disque ce qui permet de tolérer

la panne d'un contrôleur.

Ce système accroît

la sécurité des données par duplication d'un

disque sur un autre. Il améliore les performances en

lecture par accès simultanés aux 2 disques.

Et correspond au Mode Miroir de Windows NT4 Server. Ce mode est recommandé pour les serveurs de Mails.

Raid 5 :

Figure 22 : Raid 5

Le "disque de

contrôle" est réparti entre tous les disques, ce

qui élimine le goulot d'étranglement du RAID 4.

Les

disques travaillent tous autant. Si les disques sont compatibles, le

"HotPlug" peut être utilisé, ce mode

permet l'échange de disques à chaud. Il améliore

la vitesse en lecture et en écriture.

Ce mode

correspond à l'agrégat par bandes avec parité

sous NT4 Server. Ce mode est recommandé pour les serveurs

de fichiers, d'applications, de base de données, Web.

Comparatif :

|

Niveau |

Avantages |

Inconvénients |

|

RAID 0 |

|

|

|

RAID 1 |

|

|

|

RAID 3 |

|

|

|

RAID 5 |

|

|

Attention : un RAID 5 n'est pas forcément mieux qu'un RAID 0, 1 ou 3, tout dépend de l'utilisation et du but recherché.

La transmission de l’information se caractérise par :

Un délai de paquétisation

Un délai de transport

Un délai de présentation

En anglais jitter ; La gigue est la variation dans le délai de transmission ; variation du signal numérique dans le temps ou en phase.

Pour maintenir une stabilité minimale et éviter les ruptures de débit, il convient de placer une mémoire tampon ou cache en réception ; son rôle est d’assurer une indépendance minimale du débit de sortie par rapport au débit d’entrée. Une autre solution est l’insertion d’un temps de garde.

Latence, délai ou temps de réponse (en anglais delay) : elle caractérise le retard entre l'émission et la réception d'un paquet.

La liaison half-duplex (parfois appelée liaison à l'alternat ou semi-duplex) caractérise une liaison dans laquelle les données circulent dans un sens ou l'autre, mais pas les deux simultanément.

La liaison full-duplex (appelée aussi duplex intégral) caractérise une liaison dans laquelle les données circulent de façon bidirectionnelle et simultanément.

Une interruption

est utilisée pour gérer des événements

provenant de l'extérieur (clavier, souris, carte, ...)

alors qu'une exception est utilisée pour gérer des

erreurs dans le programme comme des divisions par zéro. Le

traitement déclenché produit une conséquence

identique dans les 2 cas : l'interruption du flot normal du programme

et la redirection vers une routine de traitement de cette

interruption/exception.

Au niveau interne, une

interruption est gérée par le processeur une fois

l'instruction courante terminée. Si le processeur reçoit

un signal sur sa broche d'interruption, il va rechercher l'adresse de

la routine de traitement de cette interruption dans la table des

interruptions, et transmettre le contrôle du programme à

cette routine. Une fois celle ci terminée, le processeur va

continuer l'exécution du programme à l'endroit où

il a été stoppé par l'interruption.

En

ce qui concerne les exceptions, il en existe 3 sortes :

- les

Faults : elles sont détectées et gérées

par le processeur avant les instructions ayant provoqué

la Fault

- les Traps (déroutement) : à

l'inverse des faults, elles sont gérées par le

processeur après exécution de l'instruction

ayant causé la Trap. Les interruptions définies par

l'utilisateur entrent également dans cette catégorie.

- les Aborts : utilisées uniquement pour signaler

de graves problèmes systèmes, lorsque plus aucune

opération n'est possible.

Une machine est multiprogrammé si plusieurs programmes sont chargés en mémoire dans le but de partager le CPU et de mettre à profit les "temps morts" d'un programme (par exemple les opérations d'entrée-sortie) pour "faire avancer" les autres programmes.

La multiprogrammation implique la nécessité de partager la mémoire de l'ordinateur entre plusieurs programmes, et de protéger la mémoire allouée à chacun d'eux des éventuels accès intempestifs des autres. Ceci a conduit au développement des techniques de partage de la mémoire : mémoire partitionnée, segmentée, paginée, mémoire virtuelle etc.

Le taux de multiprogrammation est le nombre de processus présents dans la mémoire d'un ordinateur à un instant donné.

La mémoire centrale est découpée en deux parties :

Image du noyau du système d’exploitation : composé de son code exécutable et ses structures de données

Reste de la RAM géré par la mémoire virtuelle :

Pour satisfaire les demandes du noyau en tampons, descripteurs et autre structures de données dynamiques du noyau.

Pour satisfaire les requêtes des processus en zones mémoire générique et en mappage de fichiers.

Pour obtenir de meilleurs performances des disques et autres périphériques utilisant des tampons par le biais des caches.

La mémoire virtuelle est une couche logique entre les requêtes des applications concernant la mémoire et l’unité matérielle de gestion de la mémoire (MMU).

La mémoire virtuelle garantie un adressage linéaire de la mémoire alors qu’en réalité les pages physiques peuvent ne pas être contiguës ou non présente en mémoire centrale.

Avantages :

exécution de plusieurs processus en même temps

plus de processus

plus de mémoire par processus

exécution de processus dont le code n’est que partiellement chargé en mémoire

chargement des pages à la demande.

Les processus peuvent partager une image mémoire unique d’un programme ou d’une librairie

Les programmes peuvent être relogé, placer n’importe où dans la mémoire

Inconvénients :

erreur de défaut de page

contrainte de programmation (performance de l’accès en mémoire)

Memory Management Unit : matériel responsable de l'accès à la mémoire demandée par le microprocesseur.

La pagination à la demande (demand paging) : si le processus adresse une donnée non présente en mémoire centrale, il génère une exception (fault page ; erreur de pagination). Alors le gestionnaire de la mémoire (MMU) trouve et affecte une zone mémoire physique (une page) au processus puis il initialise les données de la page pour le processus.

La copie à l’écriture (Copy On Write) : tant que les processus utilisent des données identiques sans les modifier, le gestionnaire de mémoire physique leur donne une référence en mémoire identique. Mais dès lors qu’un programme modifie une partie de données identiques, le gestionnaire de mémoire crée une copie des données initiales pour chaque processus.

Un progiciel est un logiciel commercial vendu par un éditeur sous forme d'un produit complet, plus ou moins clés en main.

Un progiciel comprend :

les composants logiciels (par exemple sous forme de CD-ROM) ;

une documentation en ligne et (ou) imprimée ;

des stages de formation ;

éventuellement une assistance à l'installation, au paramétrage et à la mise en œuvre ;

éventuellement une assistance téléphonique ;

Un processus est une tâche en train de s'exécuter. On appelle processus l'image de l'état du processeur et de la mémoire au cours de l'exécution d'un programme

Un processus (en anglais, process), est défini par :

un ensemble d'instructions à exécuter (un programme) ;

un espace mémoire pour les données de travail ;

éventuellement, d'autres ressources, comme des descripteurs de fichiers, des ports réseau, etc.

Les différents états d’un processus sont : en cours d’exécution (élu), prêt à être exécuté et bloqué. Si le système d’exploitation utilise un swap, les processus peuvent aussi prendre les état prêt à être exécuter et bloqué dans le swap.

Figure 22 : Les différents états d'un processus

Un processus est l’entité active élémentaire d’un système UNIX. C’est un programme + un contexte. Un processus est implémenté sous la forme d’une entrée dans une table à laquelle est associée une structure définissant toutes les ressources utilisées par le processus.

Figure 22 : Les différents états d'un processus UNIX

Dans un système Unix, c’est un processus qui s’exécute en permanence, en tache de fond. Aucun terminal ne lui est rattaché.

Il est créé à partir des fichiers de démarrage (/etc/init.d/rc) ou à partir d’une crontab. Tous ses descripteurs de fichier sont fermés (entrée standard, sortie standard et erreur) et son répertoire est un répertoire racine.

La principale différence entre un programme qui s’exécute en mode noyau et en mode utilisateur est que le mode noyau à un accès privilégié :

aux instructions du processeur,

à la mémoire,

aux données du système d’exploitation

et aux périphériques.

Les applications fonctionnent en mode utilisateurs et le système d’exploitation en mode noyau.

Les applications n’ont pas un accès direct aux périphériques, à la mémoire et aux données du système et ne peuvent pas ainsi les corromprent.

Une commutation de contexte (context switch) consiste à sauvegarder l'état d'un processus et à restaurer l'état d'un autre processus de façon à ce que des processus multiples puissent partager les ressources d'un seul processeur dans le cadre d'un système d'exploitation multitâche.

Une commutation de contexte peut être plus ou moins coûteuse en temps processeur suivant le système d'exploitation et l'architecture matérielle utilisés.

Le contexte sauvegardé doit au minimum inclure une portion notable de l'état du processeur (registres généraux, registres d'états, etc.) ainsi que, pour certains systèmes, les données nécessaires au système d'exploitation pour gérer ce processus.

La commutation de contexte invoque au moins trois étapes. Par exemple, en présumant que l'on veut commuter l'utilisation du processeur par le processus P1 vers le processus P2 :

Sauvegarder le contexte du processus P1 quelque part en mémoire (usuellement sur la pile de P1).

Retrouver le contexte de P2 en mémoire (usuellement sur la pile de P2).

Restaurer le contexte de P2 dans le processeur, la dernière étape de la restauration consistant à reprendre l'exécution de P2 à son point de dernière exécution.

Certains processeurs peuvent sauvegarder et restaurer le contexte du processeur en interne, évitant ainsi d'avoir à sauvegarder ce contexte en mémoire vive.

L’espace d’adressage d’un processus contient toutes les zones d’adresse de la mémoire virtuelle qu’un processus est autorisé à référencer.

Il contient :

Le code exécutable du programme (Text)

Le code exécutable et les données des librairies utilisés par le programme (en statique et les références en dynamique)

Les données initialisées du programme (DS)

Les données non initialisées du programme (CS)

La pile initiale du programme (pile en mode utilisateur et pile en mode noyau)

Le tas, soit la mémoire allouée dynamiquement par et pour le programme

Un processus léger (thread), également appelé fil d'exécution, est similaire à un processus car tous deux représentent l'exécution d'un ensemble d'instructions du langage machine d'un processeur. Du point de vue de l'utilisateur, ces exécutions semblent se dérouler en parallèle. Toutefois, là où chaque processus possède sa propre mémoire virtuelle, les processus légers appartenant au même processus père et ils se partagent sa mémoire virtuelle. Par contre, tous les processus légers possèdent leur propre pile système.

Inconvénients :

coût de la commutation de contexte

besoin de synchronisation (utilisation de sémaphores)

Pipe : tube anonyme ou tube nommé (fifo) par système de fichier

Msq : message queue ; communication asynchrone par mémoire centrale

Socket : communication synchrone et/ou asynchrone par réseau

Tableau récapitulatif de l'implémentation de la synchronisation pour les processus lourds et les processus légers.

|

Type |

processus lourd, fork wait |

processus lourd, sémaphore IPC |

processus lourd, tube |

processus lourd, message IPC |

processus lourd, segment partagé |

Java Thread |

|

Système de nommage |

PID / getPId |

cle IPC |

interne |

cle IPC |

cle IPC |

les objets |

|

nombre d'activités |

2 |

N |

2 |

N |

N |

N |

|

appel bloquant |

wait() |

p() |

read() |

receive() |

Non |

syncronized/wait() |

|

Communication |

exit(p) |

Non |

stream |

message |

taille du segment |

les objets |

|

volume de la communication |

2 octets |

Non |

non limité |

taille de la boite aux lettres |

non limité |

Machine virtuelle |

La famine est un problème que peut avoir un algorithme d'exclusion mutuelle. Il se produit lorsqu'un algorithme n'est pas équitable, c'est-à-dire qu'il ne garantit pas à tous les threads souhaitant accéder à une section critique une probabilité non nulle d'y parvenir en un temps fini.

Un interblocage (deadlock) est un phénomène qui peut survenir en programmation concurrente et qui se produit lorsque deux processus légers (thread) concurrents s'attendent mutuellement. Les processus bloqués dans cet état le sont définitivement, il s'agit donc d'une situation catastrophique.

Il n'existe aucune solution permettant d'éviter tous les interblocages. Il est par contre possible de prendre des mesures pour limiter le risque d'interblocage, à commencer par une analyse très précise de l'application à écrire.

Une méthode consiste à toujours acquérir les mutex (exclusion mutuelle) dans le même ordre. En effet, si plusieurs processus légers (thread) nécessitent d'acquérir plusieurs verrous pour effectuer leur travail, s'ils acquièrent les verrous dans un ordre différent, il est possible qu'ils se bloquent lors de la séquence d'acquisition.

Il convient aussi de s'intéresser aux priorités des processus. En effet, si par exemple un processus de haute priorité utilise un verrou en commun avec un processus de basse priorité (voir aussi inversion de priorité), il est possible d'obtenir des situations de blocage. Une solution à ce genre de problème consiste à n'utiliser des verrous qu'entre des processus de même priorité.

C’est une variable protégée qui constitue une méthode utilisée couramment pour restreindre l'accès à des ressources partagées (par exemple un espace de stockage) dans un environnement de programmation concurrente. Sa protection consiste à pouvoir être testé et modifié au cours d'un cycle insécable (masquage des interruptions pendant l’accès au sémaphore).

Les trois opérations prises en charge sont Init, P et V. Elles signifient tester, et incrémenter (en français "Puis-je?" et "Vas-y!"). La valeur d'un sémaphore est le nombre d'unités de ressource (exemple : imprimantes...) libres ; s'il n'y a qu'une ressource, un sémaphore à système numérique binaire avec les valeurs 0 ou 1 est utilisé.

Figure 22 : Les opérations sur un sémaphore

Le sémaphore SEM, sa liste L et son compteur K, SEM sont accessibles aux opérations:

INIT(SEM, VAL)

P(SEM)

V(SEM)

Pour éviter l'attente, un sémaphore peut avoir une file de processus associée (généralement une file du type FIFO). Si un processus exécute l'opération P sur un sémaphore qui a la valeur zéro, le processus est ajouté à la file du sémaphore. Quand un autre processus incrémente le sémaphore en exécutant l'opération V, et qu'il y a des processus dans la file, l'un d'eux est retiré de la file et reprend la suite de son exécution.

Les producteurs/consommateurs

Les lecteurs/rédacteurs

Le dîner des philosophes

Un Mutex (Exclusion mutuelle) est une primitive de synchronisation utilisée en programmation pour éviter que des ressources partagées d'un système ne soient utilisées en même temps.

Un Mutex est un sémaphore initialisé à 1.

L'inversion de priorité est un phénomène qui peut se produire en programmation concurrente. Il s'agit d'une situation dans laquelle un processus de haute priorité ne peut pas avoir accès au processeur car il est utilisé par un processus de plus faible priorité.

Phénomène qui se produit lorsque des processus utilisent des ressources partagées protégées par des sémaphores communs.

Solutions : Il n'existe pas de solution simple permettant d'éviter toutes les inversions de priorité. Il est néanmoins possible de prendre des mesures pour limiter ces risques. En particulier, il est possible de

N'autoriser l'accès à des sections critiques qu'à des threads de même priorité.

Utiliser des sémaphores adaptés, par exemple des sémaphores à héritage de priorité ou des sémaphores à priorité plafond.

Un signal est une interruption logicielle émise vers un processus pour lui indiquer l’arrivée d’un événement attendu ou non. L’émetteur d’un signal ne peut pas connaître l’attitude adoptée par le destinataire, en particulier si celui-ci a décidé d’ignorer l’arrivée du signal, l’émetteur n’en saura rien.

Les signaux peuvent être envoyés :

d’un processus à un autre : on utilise alors l’appel système kill() ;

par le noyau à un processus : pour indiquer, par exemple, une erreur fatale qui provoquera l’arrêt du processus

Ensemble de logiciels exécutés sur un ordinateur exploitant l’ordinateur afin d’offrir aux programmes des services et aux programmeurs un accès simplifiés aux ressources de la machine.

Un système d’exploitation est spécifique à une famille de processeur (exemple : x86)

Il gère :

la mémoire

les entrées/sorties

les interruptions et le processeur

les fichiers

les processus

Unix

Windows

MacOS

Netware de Novell

Avantages :

Libère l’utilisateur de tout problème d’exploitation qui ne se soucie que de la mise au point de ses programmes. Le reste de l’administration étant du ressort de l’administrateur système

Solution simple aux partages d’informations entre les usagers.

Transparence de l’architecture matérielle

Inconvénients :

Très sensibles aux variations de charge

Difficile d’adapter une configuration donnée aux besoins immédiats

Sensible aux pannes, indisponibilité du système sur changement d’un équipement

Coût financier élevé

Un système distribué est un ensemble de station de travail utilisable simultanément par des usagers. Chaque station possèdent son système d’exploitation et est reliée aux autres pour permettre l’échange d’information. C’est l’aspect communication qui fait son point faible et son point fort.

Avantages :

Hétérogénéité des systèmes : plusieurs machines de nature différente (calculateur vectoriel, gestionnaire de fichier, poste de travail)

Croissance modulaire

Grande disponibilité : possibilité d’arrêter un élément de l’architecture sans arrêt complet

Inconvénients :

Absence d’état globale

Le partage d’information : pas de mémoire commune ; données répliquées pour plus de disponibilité entraîne une politique de mise à jour complexe ;

Administration système difficile : cohérence entre administrateurs systèmes localisés sur des sites différents.

Une architecture client serveur est un système composé de deux programmes, un client et un serveur, pouvant être exécuté sur un même ordinateur ou sur deux ordinateurs distant. Les deux programmes communique généralement par une interface réseau.

Le client est une entité qui demande l’accès à un service ou à une ressource.

Le serveur est une entité qui rend le service ou qui attribue la ressource. A chaque serveur est associé une adresse de service. En réseau il s’agit d’un numéro de port (entier de 0 à 65535). Un serveur se caractérise par son interface qui spécifie les services qu’il fournit et leur mode d’utilisation. Il existe deux types de processus serveurs :

Les serveurs itératifs : le processus traite lui-même la réponse. Ce type de serveur est utilisable lorsque le temps de traitement est très court, ou si 1 seul client utilise le serveur.

Les serveurs parallèles : le processus invoque un autre processus pour traiter la requête du client. Ce processus est crée par l’appelle système fork() ; le processus père ne se bloque pas sur la fin de l’exécution de son fils et peut ainsi se remettre en attente d’autres requêtes.

Il existe deux types de serveur selon les traitements réalisés :

Les serveurs sans états (state less) : ne conservent aucune information sur les clients

Les serveurs avec état (state full) : conservent des informations sur l’état de ces clients après chaque requête.

En cas de rupture de la communication, les reprises sont plus ou moins simples avec les serveurs sans état mais peuvent donner lieu parfois à des fonctionnements aléatoires.

Figure 22 : Architecture Client/Serveur

L'architecture 3-tier (de l'anglais tier signifiant étage ou niveau) est un modèle logique d'architecture applicative qui vise à séparer très nettement trois couches logicielles au sein d'une même application ou système, à modéliser et présenter cette application comme un empilement de trois couches, étages, niveaux ou strates dont le rôle est clairement défini :

la présentation des données : correspondant à l'affichage, la restitution sur le poste de travail, le dialogue avec l'utilisateur ;

le traitement métier des données : correspondant à la mise en œuvre de l'ensemble des règles de gestion et de la logique applicative ;

et enfin l'accès aux données persistantes (persistancy en anglais) : correspondant aux données qui sont destinées à être conservées sur la durée, voire de manière définitive.

Dans cette approche, les couches communiquent entre elles au travers d'un « modèle d'échange », et chacune d'entre elles propose un ensemble de services rendus. Les services d'une couche sont mis à disposition de la couche supérieure. On s'interdit par conséquent qu'une couche invoque les services d'une couche plus basse que la couche immédiatement inférieure ou plus haute que la couche immédiatement supérieure (chaque niveau ne communique qu'avec ses voisins immédiats).

Le rôle de chacune des couches et leur interface de communication étant bien définis, les fonctionnalités de chacune d'entre elles peuvent évoluer sans induire de changement dans les autres couches. Cependant, une nouvelle fonctionnalité de l'application peut avoir des répercussions dans plusieurs d'entre elles. Il est donc essentiel de définir un modèle d'échange assez souple, pour permettre une maintenance aisée de l'application.

Ce modèle d'architecture 3-tier a pour objectif de répondre aux préoccupations suivantes :

allégement du poste de travail client (notamment vis-à-vis des architectures classiques client-serveur de données –- typiques des applications dans un contexte Oracle/Unix) ;

prise en compte de l'hétérogénéité des plates-formes (serveurs, clients, langages, etc.) ;

introduction de clients dits « légers » (plus liée aux technologies Intranet/HTML qu'au 3-tier proprement dit) ;

et enfin, meilleure répartition de la charge entre différents serveurs d'application.

Précédemment, dans les architectures client-serveur classiques, les couches présentation et traitement étaient trop souvent imbriquées. Ce qui posait des problèmes à chaque fois que l'on voulait modifier l'IHM du système.

L'activation à distance (entre la station et le serveur d'application) des objets et de leurs méthodes (on parle d'invocation) peut se faire au travers d'un ORB (avec le protocole IIOP ou au moyen des technologies COM/DCOM de Microsoft ou encore avec RMI en technologie J2EE). Cette architecture ouverte permet également de répartir les objets sur différents serveurs d'application (soit pour prendre en compte un existant hétérogène, soit pour optimiser la charge).

Il s'agit d'une architecture logique qui se répartit ensuite selon une architecture technique sur différentes machines physiques, bien souvent au nombre de 3, 4 ou plus. Une répartition de la charge doit dans ce cas être mise en place.

Logiciel qui interprète les instructions d’un programme.

Avantages : facilement portable (indépendant de l’OS)

Inconvénients : lent

Un ramasse-miettes, ou récupérateur de mémoire, ou glaneur de cellules (en anglais garbage collector, abrégé en GC) est un sous-système informatique de gestion automatique de la mémoire. Il est responsable du recyclage de la mémoire préalablement allouée puis inutilisée.

Le principe de base de la récupération automatique de la mémoire est simple :

déterminer quels objets dans le programme ne peuvent pas être utilisés,

récupérer le stockage utilisé par ces objets.

Bien qu'en général il soit impossible de déterminer à l'avance à quel moment un objet ne sera plus utilisé, il est possible de le découvrir à l'exécution : un objet sur lequel le programme ne maintient plus de référence, donc devenu inaccessible, ne sera plus utilisé.

Les ramasse-miettes utilisent un critère d'accessibilité pour déterminer si un objet peut être potentiellement utilisé.

Les principes sont :

un ensemble distinct d'objets qui sont supposés atteignables, ce sont les racines. Dans un système typique ces objets sont les registres machine, la pile, le pointeur d'instruction, les variables globales. En d'autres termes tout ce qu'un programme peut atteindre directement.

tout objet référencé depuis un objet atteignable est lui-même atteignable.

Dit autrement : un objet atteignable peut être obtenu en suivant une chaîne de pointeurs ou de références.

Bien évidemment, un tel algorithme est une approximation conservatrice de l'objectif idéal de destruction des valeurs ne servant plus : certaines valeurs peuvent fort bien être accessibles depuis les racines mais ne plus jamais être utilisées. Cet objectif idéal est cependant inaccessible algorithmiquement : déterminer quelles valeurs serviront dans le futur est équivalent au problème de l'arrêt.

Cette approximation conservatrice est la raison de la possibilité de fuites de mémoire, c'est-à-dire de l'accumulation de blocs de mémoire qui ne seront jamais réutilisés, mais jamais libérés non plus. Par exemple, un programme peut conserver un pointeur sur une structure de donnée qui ne sera jamais réutilisée. Il est pour cette raison recommandé d'écraser les pointeurs vers des structures inutilisées, afin d'éviter de conserver des références inutiles.

L'algorithme du ramasse-miettes est dû à Schorr et Waite. Les ramasse-miettes effectuent des cycles de ramassage. Un cycle est démarré lorsque le récupérateur décide (ou est notifié) qu'il doit récupérer de l'espace de stockage. Un cycle est constitué des étapes suivantes :

Créer des ensembles dits noir, gris et blanc. Initialement, l'ensemble noir est vide, l'ensemble gris contient les objets « racines » et éventuellement certains objets supplémentaires choisis en fonction de l'algorithme particulier employé, et l'ensemble blanc contient tout le reste. À tout moment dans l'exécution de l'algorithme, un objet ne peut être que dans un seul des trois ensembles. L'ensemble blanc peut être vu comme l'ensemble des objets dont nous essayons de récupérer l'espace mémoire ; au cours du cycle, l'algorithme ôtera des objets de l'ensemble blanc, y laissant les objets dont il peut réclamer l'espace mémoire.

Choisir un objet de l'ensemble gris, déplacer cet objet vers l'ensemble noir, déplacer tous les objets blancs référencés directement par cet objet vers l'ensemble gris. Cette étape est répétée jusqu'à ce qu'il n'y ait plus d'objets dans l'ensemble gris.

Quand il n'y a plus d'objets dans l'ensemble gris, alors tous les objets restant dans l'ensemble blanc ne sont pas atteignables, et l'espace mémoire qu'ils utilisent peut être réclamé.

L'invariant des trois couleurs peut être traduit comme ceci : aucun objet noir ne pointe directement sur un objet blanc.

L'algorithme de base à plusieurs variantes.

Les ramasse-miettes qui déplacent les objets en mémoire (qui changent leur adresse), dits stop and copy.

Certains récupérateurs peuvent correctement identifier toutes les références à un objet : ils sont appelés des récupérateurs « exacts », par opposition avec des récupérateurs « conservateurs » ou « partiellement conservateurs ». Les ramasse-miettes « conservateurs » doivent présumer que n'importe quel suite de bits en mémoire est un pointeur si (lorsqu'ils sont interprétées comme un pointeur) il pointe sur un quelconque objet instancié. Ainsi, les récupérateurs conservateurs peuvent avoir des faux négatifs, où l'espace mémoire n'est pas réclamé à cause des faux pointeurs accidentels. En pratique ceci est rarement un gros inconvénient.

Le ramasse-miettes peut s'exécuter en alternance ou en parallèle avec le reste du système ; les récupérateurs les plus simples suspendent l'exécution du système lorsqu'ils exécutent un cycle ; ils ne sont pas incrémentaux ; les récupérateurs incrémentaux entrelacent leur travail pour s'exécuter pendant les temps d'inactivité du reste du système. Certains récupérateurs incrémentaux peuvent s'exécuter complètement en parallèle dans un thread séparé ; ils peuvent en théorie s'exécuter sur un processeur différent, mais le coût de la mise en cohérence des caches rend cette approche moins pratique qu'il n'y paraît.

Classification :

Marquage et nettoyage

Ou mark and sweep en anglais. Un ramasse-miettes de ce type maintient un bit (ou deux) associé à chaque objet pour indiquer s'il est blanc ou noir ; l'ensemble gris est maintenu soit comme une liste séparée ou en utilisant un autre bit. Un récupérateur copieur distingue les objets gris et noirs en les copiant vers d'autres zones mémoire (l'espace de copie) et souvent différencie les objets noirs des objets gris en bi-partitionnant l'espace de copie (dans le cas le plus simple en maintenant un unique pointeur qui indique la séparation entre les objets noirs et gris). Un avantage des ramasse-miettes copieurs est que la libération des objets blancs (morts) se fait en vrac, en libérant en une seule fois la zone ancienne, et que le coût du ramasse-miettes est proportionnel aux nombres d'objets vivants. Ceci est particulièrement utile quand il y a beaucoup d'objets alloués, dont la plupart sont temporaires et meurent rapidement.

Ou conservative vs precise en anglais. Un ramasse-miettes est conservatif lorsqu'il ne libère pas certaines zones de mémoire devenues inutiles. Par exemple, le ramasse-miettes de Boehm considère tout mot mémoire comme un pointeur potentiel à suivre, y compris sur la pile d'appel, et s'utilise facilement en C. Au contraire, les ramasse-miettes précis distinguent partout les pointeurs des autres données (y compris sur la pile d'appel) et nécessitent pour ce faire la coopération du compilateur (qui va génèrer les descripteurs de cadre d'appels) ou du programmeur. Généralement, les ramasse-miettes conservatifs sont marqueurs et ne modifient pas l'adresse des zones utilisées.

Ou generational GC en anglais. Toutes les données d'un programme n'ont pas la même durée de vie. Certaines sont éliminables très peu de temps après leur création (par exemple, une structure de donnée créée uniquement pour retourner une valeur d'une fonction, et démantelée dès que les données en ont été extraites). D'autres persistent pendant toute la durée d'exécution du programme (par exemple, des tables globales créées pendant l'initialisation). Un ramasse-miettes traitant toutes ces données de la même façon n'est pas forcément des plus efficaces.

Une solution serait de demander au programmeur d'étiqueter les données créées selon leur durée de vie probable. Cependant, cette solution serait lourde à utiliser ; par exemple, il est courant que les données soient créées dans des fonctions de bibliothèque (par exemple, une fonction créant une table de hachage), il faudrait leur fournir les durées de vie en paramètre.

Une méthode moins invasive est le système des générations. Le ramasse-miettes opère alors sur une hiérarchie de 2 ou plus générations, étagées de la plus « jeune » à la plus « âgée ». Les données nouvellement créées sont (en général) placées dans la génération la plus jeune. On ramasse assez fréquemment les miettes dans cette génération jeune ; les données encore présentes à l'issue de la destruction des données inaccessibles de cette génération sont placées dans la génération d'âge supérieur, et ainsi de suite. L'idée est que les données de plus courte durée de vie n'atteignent, pour la plupart, pas la génération supérieure (elle peuvent l'atteindre si elles viennent d'être allouées quand le ramassage de miettes les repère dans la génération jeune, mais c'est un cas rare).

On utilise généralement 2 ou 3 générations, de tailles croissantes. Généralement, on n'utilise pas le même algorithme de ramasse-miettes pour les diverses générations. Il est ainsi courant d'utiliser un algorithme non incrémental pour la génération la plus jeune : en raison de sa faible taille, le temps de ramasse-miettes est faible et l'interruption momentanée de l'exécution de l'application n'est pas gênante, même pour une application interactive. Les générations plus anciennes sont plutôt ramassées avec des algorithmes incrémentaux.

Le réglage des paramètres d'un ramasse-miettes à génération peut être délicat. Ainsi, la taille de la génération la plus jeune peut influencer de façon importante le temps de calcul (un surcoût de 25%, par exemple, pour une valeur mal choisie) : temps de ramasse-miettes, impact sur la localité du cache... Par ailleurs, le meilleur choix dépend de l'application, du type de processeur et d'architecture mémoire.

Une solution qui vient vite à l'esprit pour la libération automatique de zones de mémoire est d'associer à chacune un compteur donnant le nombre de références qui pointent sur elle. Ces compteurs doivent être mis à jour à chaque fois qu'une référence est créée, alterée ou détruite. Lorsque le compteur associé à une zone mémoire atteint zéro, la zone peut être libérée.

Cette technique souffre d'un inconvénient certain lors de l'usage de structures cycliques : si une structure A pointe sur une structure B qui pointe sur A (ou, plus généralement, s'il existe un cycle dans le graphe des références), mais qu'aucun pointeur extérieur ne pointe ni sur A ni sur B, les structures A et B ne sont jamais libérées : leurs compteurs de références sont strictement supérieurs à zéro (et comme il est impossible que le programme accèdent à A ou B, ces compteurs ne peuvent jamais repasser à zéro).

En raison de ces limites, certains considèrent que le comptage de références n'est pas une technique de récupération de mémoire à proprement parler ; ils restreignent le terme de récupération de mémoire à des techniques basées sur l'accessibilité.

Le comptage de références souffre de certains problèmes sérieux, comme son coût élevé en temps de calcul et aussi en espace mémoire et, comme on l'a vu, l'impossibilité de gérer les références circulaires. D'un autre côté, il récupère les « miettes » plutôt vite, ce qui présente des avantages s'il y a des destructeurs à exécuter pour libérer les ressources rares (sockets...) autres que le tas (mémoire).

Des systèmes hybrides utilisant le comptage de références pour obtenir la libération quasi immédiate des ressources, et appelant à l'occasion un récupérateur de type Mark and Sweep pour libérer les objets contenant des cycles de références, ont été proposés et parfois implémentés. Cela donne le meilleur des deux mondes, mais toujours au prix d'un coût élevé en termes de performances.

Avantages et inconvénients

Les langages utilisant un ramasse-miettes permettent d'écrire des programmes plus simples et plus sûrs. La mémoire étant gérée automatiquement par l'environnement d'exécution, le programmeur est libéré de cette tâche, source de nombreuses erreurs difficiles à débusquer. La gestion manuelle de la mémoire est l'une des sources les plus courantes d'erreur.

Trois types principaux d'erreurs peuvent se produire :

l'accès à une zone non allouée, ou qui a été libérée,

la libération d'une zone déjà libérée,

la non-libération de la mémoire inutilisée (fuites mémoire).

L'utilisation d'outils et de méthodologie appropriés permet d'en réduire l'impact, tandis que l'utilisation d'un ramasse-miettes permet de les éliminer presque complètement – les fuites de mémoire restent possibles, bien que plus rares. Cette simplification du travail de programmation peut présenter quelques inconvénients, principalement au niveau des performances des programmes les utilisant.

Des mesures montrent que dans certains cas l'implémentation d'un ramasse-miettes augmente les performances d'un programme, dans d'autre cas le contraire se produit. Le choix des paramètres du ramasse-miettes peut aussi altérer ou améliorer significativement les performances d'un programme. Lorsque le ramasse-miettes effectue de nombreuses opérations de copies en tâche de fond (cas de l'algorithme stop-and-copy), il tend à défragmenter la mémoire. Le ramasse-miettes peut ainsi se révéler plus rapide qu'un codage ad-hoc de l'allocation/désallocation. Les meilleures implémentations peuvent aussi optimiser l'utilisation des caches mémoires, accélérant ainsi l'accès aux données. A contrario, l'opération de collection est souvent coûteuse.

Il est difficile de borner le temps d'exécution de la phase de collection des objets non atteignables. L'utilisation d'un ramasse-miettes standard peut donc rendre difficile l'écriture de programmes temps réel ; un ramasse-miettes spécialisé (temps-réel) doit être utilisé pour cela.

Sans intervention du programmeur, un programme utilisant un ramasse-miettes a tendance à utiliser plus de mémoire qu'un programme où la gestion est manuelle (en admettant que, dans ce cas, il n'y a pas de fuites, d'erreur d'accès ou de libération). Toutefois, rien n'interdit d'employer des stratégies de pré-allocation des objets utilisés, dans des pools, lorsqu'on veut minimiser le taux d'allocation/désallocation. Dans ce cas, le ramasse-miettes fournit toujours le bénéfice d'une programmation sans erreur grave de gestion de la mémoire (une assurance).

Bien que ce ne soit pas le but d'un ramasse-miettes son implémentation peut aussi faciliter l'implémentation de la persistance d'objet (certains algorithmes sont partagés).

A identifier la partie de l'adresse représentant le réseau. Ce masque est composé de 32 bits: les bits représentant le réseau sont positionné à 1.

A identifier la partie adresse représentant des sous- réseaux (subnet, ou segment logique, ou segment IP) destinés à créer des structures logiques au niveau du réseau d'entreprise.

Exemple : mask = 255.255.0.0 pour un réseau de class B 155.1.54.0

Si le premier bit est à 0, il s'agit d'une classe A (en décimal de 1.0.0.0 à 127.0.0.0)

Si les 2 premiers bits sont à 1 0, il s'agit d'une classe B (en décimal de 128.0.0.0 à 191.0.0.0).

Si les 3 premiers bits sont 1 1 0, il s'agit d'une classe C (en décimal de 192.0.0.0 à 254.0.0.0).

Une adresse Ethernet, aussi appelé adresse MAC (Media Access Control) ou adresse physique, est un identifiant unique géré par un organisme international et associé à une carte réseau par son constructeur. Cette adresse permet d’identifier la carte réseau sur un réseau Ethernet.

Elle se compose de 8 octets en hexadécimal (exemple : 00-1B-77-B9-1F-AA)

C’est une adresse qui permet d’adresser toutes les machines d’un même réseau. Elle est généralement obtenue en positionnant à 1 tous les bits correspondants à la partie adresse d’un réseau.

Exemple : pour un réseau de classe C avec comme adresse 192.168.1.0 et comme masque 255.255.255.0, l’adresse de diffusion est 192.168.1.255

Etoile : nœud central qui supporte toute la charge ; un équipement, concentrateur ou Hub, connecte toutes les stations entre elles ; Si le concentrateur tombe en panne le réseau ne fonctionne plus, par contre une station peut être retiré sans planter le réseau.

Bus : réseau à diffusion ; l'information passe 'devant' chaque noeud et s'en va 'mourir' à l'extrémité du bus sur le bouchon. Utilisation de câble coaxial pour réaliser des réseaux Ethernet 10base2 et 10base5. Si un nœud du bus est déconnecté le réseau entier tombe.

Boucle (anneau) : réseau décentralisé type point à point. Ex : Token Ring dIBM. L'information transite par chacun d'eux et retourne à l'expéditeur

Maillé : tous les nœuds sont connectés entre eux

Arbre : hiérarchique. Les nœuds sont reliés aux nœuds supérieurs (ex réseau téléphonique)

Open System Interconnexion : assure interopérabilité des systèmes communicant par réseau.

L’interopérabilité des systèmes est garantie par la définition de relation verticale (interface) dans le découpage en couche des différents logiciels réseaux et de relation horizontale (protocole d’échange) entre deux couches de deux systèmes.

Les différents logiciels réseaux sont réparties en 7 couches dont les couches 1, 2, 3 et 4 qui réalise la transmission de l’information et les couches 5, 6 et 7 qui traite, gère l’application.

Figure 22 : Les 7 couches du modèle OSI

Niveau 1 : couche physique + couche physique ; transmission de séquence de bit sur un circuit de communication (média) entre deux systèmes. Les éléments de la couche physique sont : support physique, codeur, modulateur, multiplexeur, concentrateur.

Niveau 2 : couche liaison (utilise la couche physique) ; gestion de la liaison de donnée : données de l’émetteur en trame de données, transmission des trames en séquence, gestion des trames d’acquittement, reconnaissances des frontières des trames envoyées par la couche physiques ; détection et reprise sur erreur : régulation du trafic et gestions des erreurs ; procédures de transmissions (HDLC, LLC, DSC)

Niveau 3 : couche réseau (interconnexion de réseau hétérogène) ; fournit le moyen d’établir, de maintenir et de libérer des connexions de réseaux entre des systèmes ouverts : gestion de sous réseau, acheminement des paquets de la source vers la destination ; fonctionnalités d’adressage, de routage et de contrôle de flux ; Mode connecté ou non connecté ; Exemple IP

Niveau 4 : couche transport ; Indépendant des réseaux sous-jacents ; Accepte les données de la couche session les découpe et les ordonne ; fonctionnalités de bout en bout ; dépendance aux services réseaux de QoS. Ex : TCP, UDP

Niveau 5 : couche session ; met en place et contrôle la connexion (synchronisation) entre deux processus : gestion du dialogue, point de reprise, retour arrière

Niveau 6 : couche présentation : s’intéresse à la syntaxe et à la sémantique de l’information échangée entre deux applications : modèle de donnée échangé, compression et chiffrement.

Niveau 7 : couche application

L’IPV6 permet de traiter de façon adaptée les flux en temps réel, de sélectionner un fournisseur de service et l’adressage multipoint.

Adresse anycast : sélection du fournisseur d’accès en fonction de critère de bande passante de qualité de service, de prix, etc.

Indicateur de flux : pour repérer les paquets d’un même type de flux

Niveau de priorité :

Asynchronous Transfer Mode : technique de commutation et de multiplexage de cellules de longueurs fixes (53 bits). Il fonctionne avec un débit allant de 25 à 622 Mbps.

Fonctionnalités :

traite les flux en fonction de leur nature,

garantie de la bande passante.

Inconvénients : offres limités sur le marché français ; coûts prohibitifs (acquisition des Codecs MPEG2) ;

Avantages : adaptés pour la visioconférence

LAN: Local Area Network

Ces réseaux sont en général circonscrits à un bâtiment ou à un groupe de bâtiment pas trop éloignés les uns des autres (site universitaire, usine ou 'campus').

L'infrastructure est privée et est gérée localement par le personnel informatique.

De tels réseaux offrent en général une bande passante comprise entre 4Mbit/s et 100 Mbits/s.

WAN: Wide Area Network

Interconnexion de réseaux locaux et métropolitains à l'échelle de la planète, d'un pays, d'une région ou d'une ville.

L'infrastructure est en général publique (PTT, Télécom etc.). Les modems sont un des éléments de base des WANs. La bande passante va de quelques kbits/s à quelques Mbit/s. Une valeur typique pour une ligne louée est de 64kbits/s (en fonction des services offerts).

Un intranet est un ensemble de services Internet (par exemple un serveur web) internes à un réseau local, c'est-à-dire accessibles uniquement à partir des postes d'un réseau local, ou bien d'un ensemble de réseaux bien définis, et invisibles (ou inaccessibles) de l'extérieur. Il consiste à utiliser les standards client-serveur de l'internet (en utilisant les protocoles TCP/IP), comme par exemple l'utilisation de navigateurs internet (client basé sur le protocole HTTP) et des serveurs web (protocole HTTP), pour réaliser un système d'information interne à une organisation ou une entreprise.

Un extranet est une extension du système d'information de l'entreprise à des partenaires situés au-delà du réseau. Un extranet n'est donc ni un intranet, ni un site internet. Il s'agit d'un système supplémentaire offrant par exemple aux clients d'une entreprise, à ses partenaires ou à des filiales, un accès privilégié à certaines ressources informatiques de l'entreprise par l'intermédiaire d'une interface Web.

Internet est le réseau informatique mondial qui rend accessibles au public des services comme le courrier électronique et le World Wide Web. Techniquement, Internet se définit comme le réseau public mondial utilisant le protocole de communication IP (Internet Protocol).

En définitive, du point de vue de la confidentialité des communications, il importe de distinguer Internet des intranets, les réseaux privés au sein des entreprises, administrations, etc., et des extranets, interconnexions d'intranets pouvant emprunter Internet.

Quelles sont les différentes techniques d’accès à un média pour envoi et la réception d’information ? Qu'est-ce que CSMA/CD sur un réseau de type Ethernet ?

Consiste à nommer sur le réseau une machine responsable de gérer les accès en attribuant un droit de parole à chaque noeud de façon régulière ou en fonction de priorités ; cette tâche est en général accomplie par le serveur central. Cette méthode, appelée tour de table ou polling, tient difficilement compte des besoins réels de chaque noeud et ne permet pas une très grande souplesse; elle ne subsiste plus que dans certains gros systèmes à base de terminaux.

Il s'agit d'un système complètement déterministe.

Le droit de parole est attribué au possesseur d'un jeton (token) qui circule sur le réseau. Le noeud qui possède le jeton peut disposer du réseau; il le restitue lorsqu'il a fini de transmettre ses informations; un autre noeud peut ainsi en disposer.

Cette méthode, adoptée par IBM (TokenRing), convient particulièrement bien aux réseaux en anneau (ring).

En fonction de la longueur totale du câble, du nombre de stations et du temps de latence (temps mis par le paquet d'information pour traverser l'équipement) de chacune des stations, il est possible de calculer exactement la disponibilité du réseau pour chaque noeud. Il s'agit donc d'un système déterministe.

Ce type de méthode (et en particulier les réseaux TokenRing) offre un bon comportement à pleine charge, puisque de toute manière un droit de parole est attribué à intervalles fixes. Par contre, lors de faible trafic, ce mode de fonctionnement est pénalisant, puisque même si aucun autre noeud ne manifeste le besoin d'émettre sur le réseau, l'équipement désirant accéder au réseau doit attendre son tour.

Les mécanismes réglant la gestion d'un tel réseau sont particulièrement délicats à mettre en oeuvre.

CSMA/CD (Ethernet) : (Carrier Sense Multiple Access / Collision Detection)

Chaque noeud du réseau est à l'écoute du réseau (si un paquet lui est destiné, il le lit), et lorsqu'un équipement désire émettre un paquet, il ne le fait que si personne d'autre n'est train de transmettre ses propres paquets. Si le réseau est 'occupé', il attend un moment (calculé de façon aléatoire) et essaye à nouveau.

Compte tenu des caractéristiques physiques d'un réseau, un paquet (paquet 1) peut être émis par un noeud mais pas encore détectable par l'équipement désirant émettre; celui- ci transmet son paquet (paquet 2) à l'instant où le 'paquet 1' est détectable: il en résulte une collision.

Figure 22 : Accès au média par CSMA/CD sur bus Ethernet

En cas de collision, les noeuds impliqués émettent un signal pour signaler de façon certain l'événement à l'ensemble du réseau, puis essayent d'émettre à nouveau après un délai aléatoire.

Il en résulte qu'un tel réseau trop chargé fini par ne générer plus que des collisions, puisque tous les noeuds désirent émettre en même temps, alors que les 'plages' libres deviennent de moins en moins nombreuses.

On considère que les performances d'un tel réseau chutent après 30-40% de charge (3- 4 Mbits/s, à pondérer en fonction de différents paramètres, tels que la taille des paquets, le nombre de noeuds etc.).

La charge du réseau est donc un paramètre à surveiller de façon drastique si l'on ne veut pas se retrouver face à un réseau complètement surchargé et donc inutilisable.

Par contre, ses mécanismes sont relativement rustiques et sa mise en oeuvre assez simple.

Pour des raisons de physique électrique, la taille maximum des paquets envoyés sur le réseau est de 1518 bytes (12144 bits). La taille minimum est de 64 bytes (512 bits).

L'équipement récepteur a pour charge de remettre les paquets dans le bon ordre (dans le cas où, prenant des chemins différents, les paquets arrivent désordonnés) et de les ré-assembler. Cette tâche est accomplie par les couches supérieures.

RNIS : Réseau Numérique à Intégration de Service. Information numérique (son texte, vidéo) sur réseau étendu (Ex Numéris).

Sachant qu’il est impossible sur Internet de prédire le chemin emprunté par les différents paquets, la QoS permet de différencier les flux réseaux et de réserver une partie de la bande passante pour ceux nécessitant un service continu, sans coupures satisfaisant des exigences en matière de temps de réponse et de bande passante.

Trois niveaux de qualité de service :

Meilleur effort (en anglais best effort), ne fournissant aucune différenciation entre plusieurs flux réseaux et ne permettant aucune garantie. Ce niveau de service est ainsi parfois appelé lack of QoS.

Service différencié (en anglais differenciated service ou soft QoS), permettant de définir des niveaux de priorité aux différents flux réseau sans toutefois fournir une garantie stricte.

Service garanti (en anglais guaranteed service ou hard QoS), consistant à réserver des ressources réseaux pour certains types de flux. Le principal mécanisme utilisé pour obtenir un tel niveau de service est RSVP (Resource reSerVation Protocol, traduisez Protocole de réservation de ressources).

Débit

Gigue : fluctuation du signal numérique, dans le temps ou en phase

Latence, délai ou temps de réponse

Perte de paquet : non délivrance d'un paquet de données

Déséquencement : modification de l'ordre d'arrivée des paquets.

Mécanisme par lequel les données d'un équipement expéditeur sont acheminées jusqu'à leur destinataire, même si aucun des deux ne connaît le chemin complet que les données devront suivre.

Les différences entre les protocoles de routage :

ils peuvent échanger uniquement les changements dans les tables de routage comme le protocole OSPF.

ils peuvent aussi échanger toute la table de routage comme le protocole RIP ou IGRP

ou encore un hybride des deux comme EIGRP qui échangent la totalité des tables de routage dès qu'il y a modification de l'une d'elles.

OSPF (Open Shortest Path First) est un protocole de routage IP type protocole link-state (protocole à état de liens).

Ce protocole est plus performant que RIP et commence donc à le remplacer petit à petit. Contrairement à RIP qui envoie aux routeurs adjacents le nombre de sauts qui les séparent des réseaux IP, chaque routeur transmet à tous les routeurs du réseau par multicast (cf. ci-dessous), l'état de chacun de ses liens. De cette façon, chaque routeur est capable de se représenter le réseau sous la forme d'un graphe, et peut par conséquent choisir à tout moment la route la plus appropriée pour un message donné, et effectuer de l'équilibrage de charge. De plus, les mises à jour sont non périodiques et déclenchées sur des changements de topologie, ce qui entraîne un faible temps de convergence des tables de routage. Cependant, OSPF est complexe en implémentation et en configuration, et nécessite beaucoup de ressources pour stocker le graphe du réseau et effectuer les calculs sur celui-ci.

Routing Information Protocol (RIP, protocole d'information de routage) est un protocole de routage IP de type Vector Distance (Vecteur Distance) basé sur l'algorithme de routage décentralisé Bellman-Ford. Il permet à chaque routeur de communiquer aux autres routeurs la métrique, c’est-à-dire la distance qui les sépare du réseau IP (le nombre de sauts qui les sépare, ou « hops » en anglais compris entre 1 et 15). Ainsi, lorsqu'un routeur reçoit un de ces messages, il incrémente cette distance de 1 et communique le message aux routeurs directement accessibles.

Les routeurs peuvent donc conserver de cette façon la route optimale d'un message en stockant l'adresse du routeur suivant dans la table de routage de telle façon que le nombre de saut pour atteindre un réseau soit minimal. Les routes sont mises à jour toutes les 30 secondes.

Enhanced Interior Gateway Routing Protocol (EIGRP) est un protocole de routage développé par Cisco à partir de leur protocole original IGRP. EIGRP est un protocole de routage hybride IP, avec une optimisation permettant de minimiser l'instabilité de routage due aussi bien au changement de topologie qu'à l'utilisation de la bande passante et la puissance du processeur du routeur. Sa métrique est constitué de l’association de cinq différents métriques : délai, bande passante, fiabilité, charge, MTU (non utilisé dans le calcul de l'algorithme).

Wi-Fi est le nom de la certification pour les matériels respectant la norme 802.11. La norme IEEE 802.11 est un standard international décrivant les caractéristiques d'un réseau local sans fil (WLAN).

La norme définit les couches basses du modèle OSI pour une liaison sans fil utilisant des ondes électromagnétiques, c'est-à-dire :

la couche physique (notée parfois couche PHY), proposant trois types de codages de l'information.

la couche liaison de données, constitué de deux sous-couches : le contrôle de la liaison logique (Logical Link Control, ou LLC) et le contrôle d'accès au support (Media Access Control, ou MAC)

La couche physique définit la modulation des ondes radio-électriques et les caractéristiques de la signalisation pour la transmission de données, tandis que la couche liaison de données définit l'interface entre le bus de la machine et la couche physique, notamment une méthode d'accès proche de celle utilisée dans le standard ethernet et les règles de communication entre les différentes stations. La norme 802.11 propose en réalité trois couches physiques, définissant des modes de transmission alternatifs :

|

Couche Liaison de données |

802.2 |

|

|

802.11 |

|

Couche Physique ( |

DSSS FHSS Infrarouges

|

|

Standard |

Bande de fréquence |

Débit |

Portée |

|

WiFi a (802.11a) |

5 GHz |

54 Mbit/s |

10 m |

|

WiFi B (802.11b) |

2.4 GHz |

11 Mbit/s |

100 m |

|

WiFi G (802.11b) |

2.4 GHz |

54 Mbit/s |

100 m |

Les risques liés à la mauvaise protection d'un réseau sans fil sont multiples :

L'interception de données consistant à écouter les transmissions des différents utilisateurs du réseau sans fil

Le détournement de connexion dont le but est d'obtenir l'accès à un réseau local ou à internet

Le brouillage des transmissions consistant à émettre des signaux radio de telle manière à produire des interférences

Les dénis de service rendant le réseau inutilisable en envoyant des commandes factices (demande de déssassociation de station ; beaucoup de communication cryptée pour épuiser la batterie).

Infrastructure adapté : adapter la puissance d’émission par rapport à la zone à couvrir

Eviter les paramètres par défaut : mot de passe par défaut, nom du SSID, pas de broadcast du SSID.

Filtrage par adresse MAC

Le chiffrement :

WEP : algorithme symétrique RC4 avec des clés d'une longueur de 64 bits ou 128 bits ; vulnérable à une attaque par force brute (toutes les combinaisons de clé)

WPA (WiFi protected Access est une solution de

sécurisation de réseau WiFi proposé par la

WiFi Alliance, afin de combler les lacunes du WEP.

Le WPA

est une version « allégée » du

protocole 802.11i, reposant sur des protocoles d'authentification

et un algorithme de cryptage robuste : TKIP (Temporary

Key Integrity Protocol). Le protocole TKIP permet la génération

aléatoire de clés et offre la possibilité

de modifier la clé de chiffrement plusieurs fois par

secondes, pour plus de sécurité. Le

fonctionnement de WPA repose sur la mise en oeuvre d'un serveur

d'authentification (la plupart du temps un serveur RADIUS),

permettant d'identifier les utilisateurs sur le réseau et de

définir leurs droits d'accès. Néanmoins, il

est possible pour les petits réseaux de mettre en oeuvre une

version restreinte du WPA, appelée WPA-PSK, en

déployant une même clé de chiffrement dans

l'ensemble des équipements, ce qui évite la mise en

place d'un serveur RADIUS. Le WPA (dans sa première mouture)

ne supporte que les réseaux en mode infrastructure, ce qui

signifie qu'il ne permet pas de sécuriser des réseaux

sans fil d'égal à égal (mode ad hoc).

Le 802.11i a été ratifié le 24 juin 2004, afin de fournir une solution de sécurisation poussée des réseaux WiFi. Il s'appuie sur l'algorithme de chiffrement TKIP, comme le WPE, mais supporte également l'AES (Advanced Encryption Standard), beaucoup plus sûr.

La Wi-Fi Alliance a ainsi créé une nouvelle certification, baptisée WPA2, pour les matériels supportant le standard 802.11i (ordinateur portable, pda, carte réseau, etc.).

Contrairement au WPA, le WPA2 permet de sécuriser aussi bien les réseaux sans fil en mode infrastructure que les réseaux en mode ad hoc.

La norme IEEE 802.11i définit deux modes de fonctionnement :

WPA Personal : le mode « WPA personnel » permet de mettre en oeuvre une infrastructure sécurisée basée sur le WPA sans mettre en oeuvre de serveur d'authentification. Le WPA personnel repose sur l'utilisation d'une clé partagée, appelées PSK pour Pre-shared Key, renseignée dans le point d'accès ainsi que dans les postes clients. Contrairement au WEP, il n'est pas nécessaire de saisir une clé de longueur prédéfinie. En effet, le WPA permet de saisir une « passphrase » (phrase secrète), traduite en PSK par un algorithme de hachage.

WPA Enterprise : le mode entreprise impose l'utilisation d'une infrastructure d'authentification 802.1x basée sur l'utilisation d'un serveur d'authentification, généralement un serveur RADIUS (Remote Authentication Dial-in User Service), et d'un contrôleur réseau (le point d'accès)

A quel type de réseau correspond les réseaux sans fils WIFI ? Comment s'appelle l'identifiant de la borne d'accès ? Comment fonctionne la connexion à un réseau hot spot ?

Le standard 802.11 définit deux modes opératoires :

Le mode infrastructure dans lequel les clients sans fils sont connectés à un point d'accès. Il s'agit généralement du mode par défaut des cartes 802.11b.

Le mode ad hoc dans lequel les clients sont connectés les uns aux autres sans aucun point d'accès.

Le mode infrastructure

En mode infrastructure chaque ordinateur station (notée STA) se connecte à un point d'accès via une liaison sans fil. L'ensemble formé par le point d'accès et les stations situés dans sa zone de couverture est appelé ensemble de services de base (en anglais basic service set, noté BSS) et constitue une cellule. Chaque BSS est identifié par un BSSID, un identifiant de 6 octets (48 bits). Dans le mode infrastructure, le BSSID correspond à l'adresse MAC du point d'accès.